百度Spider抓取系统的基本框架介绍

>今天石家庄seo博客向朋友介绍百度蜘蛛抓取系统的基本框架。这篇博文也是石家庄百度站长学院转载的第一篇官方内容。正文内容如下:

互联网信息的爆炸式增长,如何有效地获取和利用这些信息是搜索引擎工作的首要环节。数据采集系统作为整个搜索系统的上游,主要负责收集、保存和更新互联网信息。它像蜘蛛一样在网络上爬行,所以通常被称为“蜘蛛”。比如几种常用的搜索引擎蜘蛛,叫做Baiduspdier、Googlebot、搜狗Web Spider等等。

互联网信息的爆炸式增长,如何有效地获取和利用这些信息是搜索引擎工作的首要环节。数据采集系统作为整个搜索系统的上游,主要负责收集、保存和更新互联网信息。它像蜘蛛一样在网络上爬行,所以通常被称为“蜘蛛”。比如几种常用的搜索引擎蜘蛛,叫做Baiduspdier、Googlebot、搜狗Web Spider等等。

蜘蛛爬行系统是搜索引擎数据源的重要保证。如果把web理解为一个有向图,那么Spider的工作过程可以看作是遍历这个有向图。从一些重要的种子URL开始,通过页面上的超链接关系,不断发现新的URL并进行抓取,从而抓取尽可能多的有价值的网页。对于百度这样的大型蜘蛛系统来说,由于存在网页被修改、删除或一直出现新超链接的可能性,所以需要保持蜘蛛抓取的页面更新,并维护一个URL库和一个页面库。

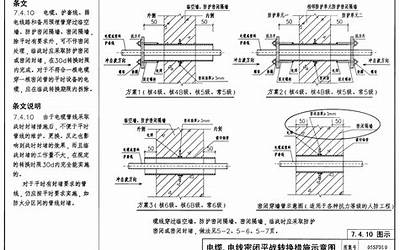

下图是蜘蛛抓取系统的基本框架,包括链接存储系统、链接选择系统、dns解析服务系统、抓取调度系统、网页分析系统、链接提取系统、链接分析系统和网页存储系统。Baiduspider就是通过这个系统的配合来完成抓取网页的工作。

原文链接:https://www.sjzseo.net/1674.html,转载请注明出处。

评论0